Ameaças reais da inteligência artificial em 2025: política deepfake e ataques de voz

A inteligência artificial (IA) já não é um conceito futurista — é uma força em rápida evolução que já penetrou na política, na cibersegurança e na comunicação pública. Em fevereiro de 2025, os abusos reais da tecnologia de IA tornaram-se cada vez mais alarmantes. Desde vídeos deepfake que imitam políticos até ferramentas de clonagem de voz utilizadas em fraudes, o uso malicioso da IA representa riscos tangíveis para as sociedades, economias e democracias.

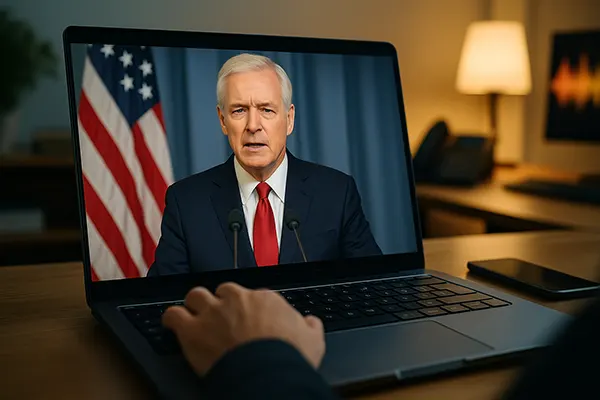

Manipulação do discurso político através de deepfakes

A tecnologia deepfake, baseada em redes adversariais generativas (GANs), atingiu um nível em que distinguir imagens reais de vídeos gerados por IA é praticamente impossível para o olho não treinado. Durante as eleições de 2024 nos EUA, vários vídeos deepfake tornaram-se virais, apresentando candidatos a fazer declarações falsas. Apesar da verificação rápida dos factos, o dano à confiança pública já estava feito, com milhões de visualizações antes da correção.

Na UE, a situação agravou-se com um caso recente na Alemanha, onde um vídeo deepfake mostrou uma líder do Partido Verde a discutir políticas ambientais falsas. Embora tenha sido desmentido em 48 horas, o vídeo provocou um aumento no assédio online e alimentou teorias da conspiração. Os governos têm dificuldade em implementar sistemas de deteção em tempo real ou regulamentos que acompanhem a velocidade destas ameaças.

Outro problema é a acessibilidade e baixo custo das ferramentas de deepfake. O que antes exigia computadores potentes e conhecimento técnico, hoje funciona em aplicações móveis. Esta democratização tecnológica significa que qualquer pessoa mal-intencionada pode criar conteúdos políticos manipulados com facilidade.

Lacunas nas políticas e limitações na deteção

Embora organizações como a Comissão Europeia e a Comissão Federal Eleitoral dos EUA tenham proposto diretrizes contra o uso indevido de deepfakes, há uma lacuna significativa entre a formulação da política e a sua aplicação. Poucos países possuem legislação penal específica para manipulação mediática gerada por IA.

Soluções técnicas, como marcação digital ou ferramentas de proveniência, ainda estão em desenvolvimento. Startups como TrueMedia e RealityGuard estão a testar sistemas de deteção, mas enfrentam adversários que evoluem rapidamente. Frequentemente, novas técnicas ultrapassam os métodos de defesa antes mesmo de serem atualizados.

As redes sociais têm papel duplo: algumas adotam avisos automáticos e etiquetas informativas, enquanto outras agem lentamente ou de forma insuficiente. A distribuição descentralizada de conteúdo dificulta a regulamentação eficaz entre fronteiras.

Clonagem de voz por IA e fraudes financeiras

A clonagem de voz, antes limitada a laboratórios de IA avançados, agora está amplamente disponível através de apps gratuitas. Com apenas alguns segundos de áudio, estas ferramentas geram réplicas vocais incrivelmente realistas. Criminosos utilizam essa tecnologia para realizar fraudes, especialmente ao imitar executivos em golpes conhecidos como “fraude do CEO”.

No início de 2025, um caso notório no Reino Unido envolveu a voz clonada de um CFO que “ligou” para autorizar uma transferência bancária, resultando num prejuízo de £2,3 milhões. A Europol relata um aumento de 320% em fraudes com voz clonada na Europa entre 2023 e 2024.

Indivíduos também são alvos. Criminosos usam IA para imitar a voz de familiares e ligam para idosos solicitando ajuda financeira urgente. Estes ataques combinam manipulação emocional com tecnologia avançada, tornando-se difíceis de detetar.

Desafios na deteção de vozes sintéticas

Diferente das fraudes por texto, os ataques com voz são íntimos e convincentes. Bancos e empresas estão a atualizar os seus protocolos de segurança, como autenticação vocal em dois fatores e detectores de anomalias com IA. Porém, os atacantes também inovam rapidamente, criando um ciclo contínuo de ataque e defesa.

Pesquisadores de Oxford e do MIT estão a desenvolver algoritmos que detetam pequenas inconsistências na fala sintética — como entonações estranhas ou pausas artificiais —, mas esses sistemas ainda exigem grande quantidade de dados e não são padrão do setor.

A biometria vocal, outrora considerada referência em segurança, perdeu fiabilidade. Instituições financeiras estão agora a recorrer a verificações comportamentais e contextuais, tendência reforçada pelos riscos da clonagem de voz.

Riscos geopolíticos e implicações para a segurança nacional

A desinformação gerada por IA não é apenas um incômodo — é uma ferramenta de guerra híbrida. Grupos apoiados por estados já utilizam deepfakes e vozes sintéticas para desestabilizar sistemas democráticos. Agências de inteligência da NATO, incluindo o GCHQ do Reino Unido, relatam um aumento nas operações psicológicas baseadas em IA.

Uma campanha envolveu operacionais russos a divulgar vídeos falsos de autoridades ucranianas supostamente a render-se, o que causou pânico antes de ser desmentido. A sofisticação destas operações indica estratégias coordenadas para minar a moral, processos eleitorais e o discurso público.

A China também testa âncoras de notícias geradas por IA para difundir mensagens do Estado no exterior. Embora legais em território chinês, estas práticas levantam preocupações sobre a manipulação global da opinião pública com conteúdo sintético.

Reforçar a governança global da IA

A cooperação internacional continua insuficiente. A UNESCO propôs uma estrutura ética para IA, mas poucos países a ratificaram. A cimeira do G7 de 2024 apelou a uma regulamentação conjunta, mas o progresso tem sido lento devido a conflitos de interesse e diferentes tradições jurídicas.

Especialistas sugerem uma abordagem multilateral, envolvendo sociedade civil, universidades e empresas tecnológicas. Uma possível solução seria a criação de organismos globais de fiscalização da IA para monitorar abusos e coordenar respostas rápidas.

No fim, o verdadeiro desafio está em educar a população a identificar e questionar conteúdos sintéticos. Campanhas de sensibilização, programas de literacia mediática e mais transparência das empresas tecnológicas são cruciais para resistir à manipulação com IA.

Tópicos populares

-

OpenTelemetry em Produção: ...

OpenTelemetry em Produção: ...Em 2026, os sistemas distribuídos deixaram de ser exceção …

-

Limitação de taxa e proteçã...

Limitação de taxa e proteçã...A limitação de taxa é um daqueles controlos que …

-

Comparação de backups em 20...

Comparação de backups em 20...Os backups são uma daquelas coisas que a maioria …

-

Redes de Alto Desempenho: P...

Redes de Alto Desempenho: P...As redes de alto desempenho tornaram-se um requisito central …

-

Edge AI e TinyML: Como a In...

Edge AI e TinyML: Como a In...A inteligência artificial ao nível do dispositivo tornou-se uma …