Minacce Reali dell’Intelligenza Artificiale nel 2025: Deepfake Politici e Attacchi Vocali

L’intelligenza artificiale (IA) non è più un concetto futuristico: è una forza in rapida evoluzione che ha già invaso la politica, la cybersicurezza e la comunicazione pubblica. A febbraio 2025, gli abusi dell’IA nel mondo reale sono diventati sempre più allarmanti. Dai video deepfake che imitano politici agli strumenti di clonazione vocale usati nelle truffe, l’uso improprio dell’IA rappresenta un pericolo concreto per le società, le economie e la democrazia.

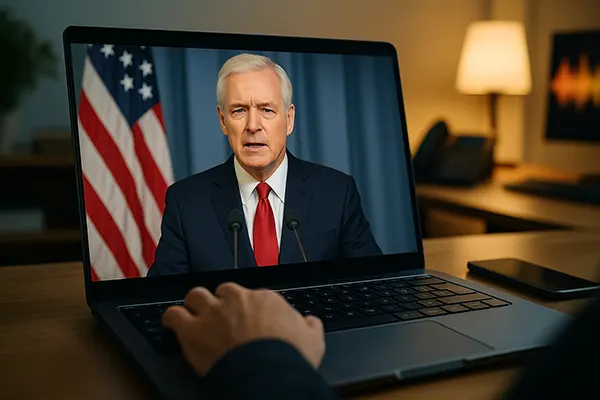

Manipolazione del Discorso Politico con i Deepfake

La tecnologia deepfake, basata su reti antagoniste generative (GAN), ha raggiunto un livello tale da rendere quasi impossibile per un occhio non esperto distinguere un video reale da uno generato dall’IA. Durante le elezioni americane del 2024, diversi video deepfake sono diventati virali, mostrando candidati intenti a pronunciare frasi mai dette. Nonostante la rapida smentita, il danno alla fiducia pubblica era già stato fatto, poiché milioni di utenti avevano già visualizzato il contenuto.

In Europa, un caso rilevante si è verificato in Germania, dove un video deepfake ha falsamente ritratto una leader del partito dei Verdi parlare di politiche climatiche inventate. Sebbene il video sia stato smascherato entro 48 ore, ha scatenato molestie online e alimentato teorie del complotto. I governi faticano a implementare sistemi di rilevamento in tempo reale e regolamenti aggiornati per contrastare queste minacce.

Preoccupante è anche l’accessibilità di queste tecnologie: una volta riservate a specialisti, oggi le app per creare deepfake funzionano su comuni smartphone. Questa democratizzazione significa che chiunque con cattive intenzioni può fabbricare contenuti politici falsi con estrema facilità.

Lacune Normative e Limiti Tecnologici

Nonostante la Commissione Europea e la Federal Election Commission americana abbiano proposto linee guida per limitare l’abuso dei deepfake, in molti paesi mancano leggi penali specifiche contro la manipolazione mediatica generata dall’IA.

Soluzioni tecniche come watermarking o strumenti di tracciabilità digitale sono ancora in fase di sviluppo. Startup come TrueMedia e RealityGuard stanno sperimentando sistemi di rilevamento, ma si scontrano con la rapidità di adattamento dei truffatori. Le tecniche evolvono più rapidamente degli strumenti creati per combatterle.

Le piattaforme social svolgono un ruolo ambiguo: alcune stanno introducendo avvisi automatici, altre sono lente a reagire. La natura decentralizzata della distribuzione dei contenuti rende complessa l’adozione di normative internazionali efficaci.

Clonazione Vocale IA e Truffe Finanziarie

Una volta riservata a laboratori avanzati, oggi la clonazione vocale è disponibile tramite app gratuite. Bastano pochi secondi di audio per generare copie vocali estremamente realistiche. I criminali sfruttano questa tecnologia per truffe di tipo “CEO fraud”.

Nel 2025, nel Regno Unito, una truffa ha visto protagonista una voce clonata del CFO di un’azienda, che ha telefonato a una banca per autorizzare un bonifico da 2,3 milioni di sterline. Non è stato un caso isolato: Europol ha registrato un aumento del 320% di frodi vocali tra il 2023 e il 2024.

Anche i privati sono bersagliati. I truffatori imitano le voci di familiari per telefonare ad anziani, fingendo di aver bisogno urgente di denaro. Questi attacchi combinano manipolazione psicologica e tecnologia avanzata, risultando difficili da rilevare.

Difficoltà nel Rilevamento delle Voci Sintetiche

Rispetto alla truffa scritta, l’inganno vocale è più personale e convincente. Le banche stanno aggiornando i protocolli di sicurezza, introducendo verifiche vocali a due fattori e rilevatori di anomalie basati su IA. Ma gli strumenti criminali evolvono altrettanto rapidamente.

Università come Oxford e MIT stanno lavorando su algoritmi in grado di identificare irregolarità vocali — ad esempio toni innaturali o pause anomale — ma servono grandi quantità di dati e non sono ancora uno standard.

Le biometrie vocali, una volta considerate sicure, stanno perdendo credibilità. Gli istituti finanziari si affidano sempre più a verifiche comportamentali e contestuali, accelerando il superamento della sola voce come fattore identificativo.

Rischi Geopolitici e Sicurezza Nazionale

La disinformazione generata dall’IA non è solo fastidiosa: è uno strumento di guerra ibrida. I servizi di intelligence della NATO, incluso il GCHQ del Regno Unito, hanno segnalato un aumento di operazioni psicologiche condotte con deepfake e voci sintetiche da parte di stati ostili.

Un esempio: operativi legati alla Russia hanno diffuso video di funzionari ucraini falsamente intenti ad arrendersi, scatenando momenti di panico prima che venissero smentiti. Queste campagne mirano a minare morale, elezioni e coesione sociale.

Anche la Cina ha sperimentato conduttori virtuali alimentati da IA nei notiziari internazionali. Sebbene legali nel proprio territorio, queste pratiche sollevano dubbi sulla possibilità che regimi autoritari influenzino l’opinione pubblica globale con contenuti sintetici.

Rafforzare la Governance Globale sull’IA

La cooperazione internazionale è ancora insufficiente. L’UNESCO ha proposto un codice etico per l’IA, ma pochi stati lo hanno recepito come legge. Il vertice G7 del 2024 ha chiesto regolamenti unificati, ma i progressi sono lenti per via delle divergenze legali.

Gli esperti raccomandano un approccio multilaterale che coinvolga società civile, accademia e settore privato. Una via da esplorare è la creazione di autorità globali che monitorino gli abusi dell’IA e coordinino risposte rapide a livello internazionale.

Infine, è fondamentale educare il pubblico a riconoscere e interrogare i contenuti sintetici. Campagne di sensibilizzazione, programmi di alfabetizzazione mediatica e trasparenza delle aziende tecnologiche sono essenziali per costruire resilienza collettiva.

Argomenti più popolari

-

OpenTelemetry in produzione...

OpenTelemetry in produzione...Nel 2026 i sistemi distribuiti rappresentano la norma piuttosto …

-

Limitation de débit et prot...

Limitation de débit et prot...La limitation de débit fait partie de ces contrôles …

-

Confronto dei backup nel 20...

Confronto dei backup nel 20...I backup sono una di quelle cose che molte …

-

High-Performance Networking...

High-Performance Networking...Il networking ad alte prestazioni è diventato un requisito …

-

Edge AI e TinyML: come l’in...

Edge AI e TinyML: come l’in...L’intelligenza artificiale eseguita a livello locale è diventata uno …