Amenazas reales de la inteligencia artificial en 2025: política deepfake y ataques de voz

La inteligencia artificial (IA) ya no es un concepto futurista: es una fuerza en rápida evolución que ha penetrado en la política, la ciberseguridad y la comunicación pública. A febrero de 2025, los abusos reales de la tecnología de IA son cada vez más alarmantes. Desde vídeos deepfake que imitan a políticos hasta herramientas de clonación de voz utilizadas en estafas, el mal uso de la IA representa riesgos tangibles para las sociedades, las economías y las democracias.

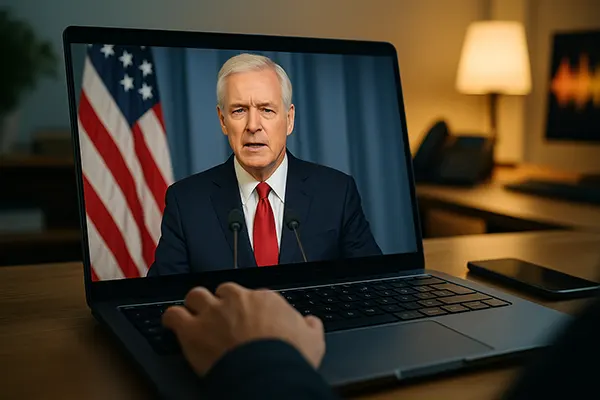

Manipulación del discurso político mediante deepfakes

La tecnología deepfake, basada en redes generativas adversariales (GANs), ha alcanzado un punto en el que distinguir entre vídeos reales y generados por IA es prácticamente imposible para el ojo no entrenado. Durante las elecciones de 2024 en EE. UU., varios vídeos deepfake se viralizaron, mostrando a candidatos diciendo cosas falsas. A pesar de las rápidas verificaciones, el daño a la confianza pública ya estaba hecho, pues millones de personas ya habían visto el contenido.

En la UE, un caso reciente en Alemania mostró a una líder del Partido Verde en un vídeo deepfake discutiendo políticas climáticas falsas. Aunque fue desmentido en 48 horas, provocó una oleada de acoso en línea y alimentó teorías conspirativas. Los gobiernos luchan por implementar sistemas de detección en tiempo real o regulaciones eficaces ante amenazas que avanzan a gran velocidad.

Otra preocupación es la accesibilidad de las herramientas deepfake. Lo que antes requería ordenadores potentes y conocimientos técnicos, hoy se puede hacer desde un smartphone. Esta democratización de la tecnología facilita que cualquier persona con malas intenciones cree contenido político falso y pueda influir en el electorado.

Vacíos normativos y límites técnicos

Aunque organismos como la Comisión Europea o la Comisión Electoral de EE. UU. han propuesto guías para limitar los deepfakes, pocos países han aprobado leyes penales específicas contra la manipulación mediática generada por IA.

Las soluciones técnicas, como marcas de agua digitales o herramientas de verificación de origen, están aún en desarrollo. Startups como TrueMedia y RealityGuard están probando sistemas de detección, pero siempre van un paso por detrás de los atacantes que innovan constantemente.

Las redes sociales tienen una doble responsabilidad: algunas introducen etiquetas automáticas y advertencias, mientras otras actúan con lentitud. La naturaleza transnacional de la distribución de contenido complica aún más la regulación efectiva.

Clonación de voz con IA y estafas financieras

La clonación de voz, antes limitada a laboratorios avanzados, está ahora disponible en aplicaciones gratuitas. Con solo unos segundos de audio, estas herramientas pueden generar réplicas de voz sorprendentemente precisas. Los delincuentes utilizan esta tecnología para cometer fraudes, especialmente mediante la suplantación de directivos en lo que ya se conoce como «fraude del CEO».

En febrero de 2025, un incidente en el Reino Unido implicó la voz clonada de un director financiero que “llamó” a un banco para autorizar una transferencia de £2.3 millones. No fue un caso aislado: Europol informó de un aumento del 320 % en estafas con voces clonadas en Europa entre 2023 y 2024.

Las personas particulares también son víctimas. Estafadores usan IA para imitar la voz de familiares y llamar a personas mayores solicitando ayuda financiera urgente. Estos ataques combinan manipulación emocional con engaño tecnológico, y son más difíciles de detectar que el phishing tradicional.

Dificultades para detectar voces sintéticas

A diferencia de los fraudes por texto, los ataques de voz son íntimos y persuasivos. Los bancos y empresas están actualizando sus protocolos de seguridad con autenticación de voz de dos factores y detectores de anomalías basados en IA. Sin embargo, las herramientas de los estafadores también evolucionan.

Investigadores de Oxford y el MIT están desarrollando algoritmos para detectar inconsistencias en el habla sintética, como irregularidades tonales o pausas extrañas, pero aún requieren muchos datos y no son estándares de la industria.

La biometría de voz, antes vista como estándar de seguridad, está perdiendo credibilidad. Las instituciones financieras ahora prefieren métodos de verificación conductuales y contextuales, debido al riesgo de clonación de audio.

Riesgos geopolíticos e implicaciones en la seguridad nacional

La desinformación generada por IA no es solo una molestia: es una herramienta de guerra híbrida. Grupos respaldados por estados ya han utilizado deepfakes y voces sintéticas para desestabilizar sistemas democráticos. Agencias de inteligencia de la OTAN, como el GCHQ del Reino Unido, han reportado un aumento de operaciones psicológicas impulsadas por IA.

Una de estas campañas, vinculada a Rusia, mostró vídeos falsos de funcionarios ucranianos rindiéndose, causando pánico momentáneo antes de ser desmentidos. La sofisticación indica una estrategia coordinada para socavar la moral y manipular procesos electorales.

China también ha probado presentadores de noticias generados por IA para transmitir mensajes estatales en el extranjero. Aunque legales en su país, estas prácticas plantean dudas sobre la influencia extranjera en la opinión pública global mediante contenido sintético.

Fortalecer la gobernanza global de la IA

La cooperación internacional sigue siendo insuficiente. Aunque la UNESCO propuso un marco ético para la IA, pocos países lo han convertido en ley. La cumbre del G7 de 2024 pidió una regulación unificada, pero los avances han sido lentos.

Los expertos recomiendan un enfoque multilateral con participación de la sociedad civil, universidades y sector privado. Una solución sería crear organismos internacionales que monitoreen el uso indebido y coordinen respuestas rápidas a nivel global.

El reto no es solo regular la tecnología, sino educar al público para que detecte y cuestione el contenido sintético. Campañas de concienciación, alfabetización mediática y transparencia por parte de las tecnológicas son esenciales para resistir la manipulación mediante IA.

Temas populares

-

OpenTelemetry en producción...

OpenTelemetry en producción...En 2026, los sistemas distribuidos ya no son una …

-

Limitación de tasa y protec...

Limitación de tasa y protec...La limitación de tasa es uno de esos controles …

-

Comparación de copias de se...

Comparación de copias de se...Las copias de seguridad son de esas cosas que …

-

Redes de Alto Rendimiento: ...

Redes de Alto Rendimiento: ...Las redes de alto rendimiento se han convertido en …

-

Edge AI y TinyML: Cómo la i...

Edge AI y TinyML: Cómo la i...La inteligencia artificial en el borde se ha convertido …