Cómo crear programáticamente un ecosistema de microservicios serverless en 2025

Crear un ecosistema de microservicios flexible y eficiente en 2025 exige comprender claramente las capacidades serverless modernas, los flujos de desarrollo, los estándares de seguridad y la automatización nativa en la nube. El enfoque que se presenta a continuación refleja las prácticas utilizadas por equipos de ingeniería que dependen de diseños serverless para escalar de forma segura, mantener la resiliencia y reducir la carga operativa sin utilizar infraestructura no gestionada.

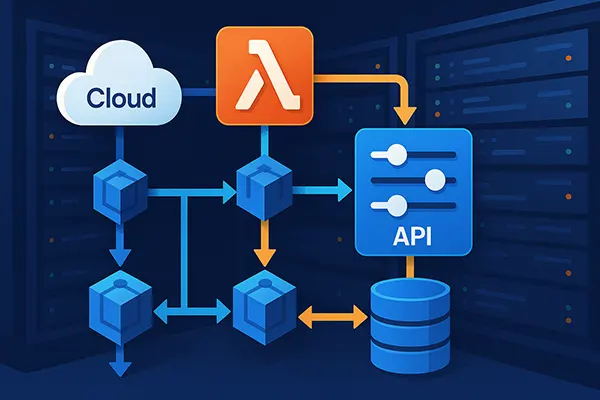

Principios de diseño para una arquitectura serverless de microservicios

En 2025, los equipos de ingeniería suelen comenzar con una estrategia de descomposición de servicios basada en dominios empresariales y no en capas técnicas. Este enfoque ayuda a mantener límites entre servicios y evita el acoplamiento excesivo, permitiendo que cada componente evolucione de forma independiente. Los proveedores de la nube ahora ofrecen un enrutamiento de eventos más avanzado, lo que facilita la implementación de límites basados en el dominio.

Los ecosistemas serverless modernos se basan en flujos de comunicación orientados a eventos. En lugar de cadenas de solicitudes síncronas, los desarrolladores utilizan buses de eventos como AWS EventBridge, Google Eventarc o Azure Event Grid. Estos sistemas reducen los cuellos de botella y mejoran la tolerancia a fallos, ya que las funciones procesan eventos de forma independiente sin bloquear otros servicios.

La gestión de la configuración desempeña un papel fundamental. Los desarrolladores suelen utilizar frameworks de infraestructura como código, como AWS CDK, Pulumi o Terraform, para definir funciones Lambda, APIs gestionadas, colas y máquinas de estado. Con IaC, los equipos garantizan entornos reproducibles y una mejor gobernanza en desarrollo, pruebas y producción.

Construyendo una base coherente para los microservicios

Para mantener la coherencia, los desarrolladores utilizan bibliotecas compartidas para registro, métricas y trazabilidad. En 2025, OpenTelemetry sigue siendo el estándar para trazas distribuidas, ofreciendo visibilidad unificada a través de servicios ejecutados por funciones serverless, contenedores o flujos gestionados. La observabilidad unifica la depuración y el monitoreo del rendimiento en todo el sistema.

Los flujos de autenticación suelen centralizarse mediante proveedores de identidad modernos. Amazon Cognito, Auth0, Azure AD B2C y Google Identity ofrecen herramientas maduras para procesos de inicio de sesión de baja fricción y validación de tokens. Cada microservicio valida tokens de forma independiente, reduciendo la necesidad de comunicación directa con los sistemas de identidad.

Los desarrolladores también dependen en gran medida de políticas automatizadas. Los proveedores de la nube incluyen reglas integradas para cifrado, rotación de secretos y límites de red. Estos controles automáticos reducen significativamente los errores de configuración manual y fortalecen la fiabilidad de los sistemas en producción.

Implementación de microservicios con funciones serverless

Las funciones serverless siguen siendo las unidades principales de ejecución en los ecosistemas de microservicios en 2025. AWS Lambda, Google Cloud Functions y Azure Functions ofrecen alto rendimiento, tiempos de arranque en frío reducidos y la posibilidad de ejecutar operaciones más largas e intensivas que en años anteriores. Muchos equipos combinan funciones serverless con contenedores ejecutados en plataformas serverless como AWS Fargate o Cloud Run.

Los API Gateways funcionan como puntos de entrada controlados para la comunicación externa. Mediante reglas de enrutamiento, políticas de limitación y validación de solicitudes, los API Gateways garantizan un comportamiento predecible en los endpoints. Esto asegura estabilidad cuando la demanda del usuario aumenta inesperadamente.

La gestión del estado se logra mediante bases de datos gestionadas y motores de flujos de trabajo. DynamoDB, Firestore, Azure Cosmos DB y servicios relacionales nativos de la nube soportan transacciones, esquemas flexibles y escalado automático. Para flujos complejos, los desarrolladores confían en Step Functions, Cloud Workflows o Durable Functions para orquestar operaciones.

Patrones eficientes para microservicios serverless

El encadenamiento de funciones basado en eventos es ahora un enfoque común. En lugar de escribir controladores monolíticos, los desarrolladores dividen la lógica en funciones dedicadas activadas por colas o buses de eventos. Esto mejora el procesamiento en paralelo, reduce la latencia y crea patrones de escalado predecibles en cargas elevadas.

El patrón de saga continúa creciendo en popularidad para operaciones distribuidas. Al coordinar transacciones locales entre servicios y compensar cuando ocurren errores, los desarrolladores garantizan la consistencia de datos sin depender de transacciones estrechamente acopladas. Los motores de flujos ayudan a implementar sagas de manera transparente.

La optimización de costes también se realiza de forma programática. Los equipos monitorizan la duración de las funciones, la asignación de memoria y los límites de concurrencia, ajustándolos mediante pipelines de IaC. Las herramientas modernas pueden recomendar ajustes óptimos automáticamente, reduciendo costes sin sacrificar rendimiento.

Seguridad, CI/CD y prácticas operativas en 2025

Las prácticas de seguridad en 2025 se basan en la aplicación automática de políticas. Los proveedores de la nube ofrecen conjuntos de reglas predefinidas que validan políticas IAM, exposición de APIs y configuraciones de almacenamiento de datos. Los desarrolladores integran estos análisis en los pipelines de CI/CD para detectar riesgos con antelación.

Los pipelines de integración continua utilizan entornos de compilación efímeros para minimizar riesgos en la cadena de suministro. GitHub Actions, GitLab CI y AWS CodeBuild soportan artefactos firmados y almacenamiento resistente a manipulaciones, un estándar mínimo en entornos empresariales.

Los procesos operativos se benefician del escalado automático y del monitoreo avanzado. Con análisis en tiempo real proporcionados por CloudWatch, Stackdriver o Azure Monitor, los ingenieros pueden detectar anomalías rápidamente. El monitoreo predictivo impulsado por IA también ayuda a anticipar picos y ajustar políticas de capacidad antes de que ocurran.

Mantenimiento y gobernanza a largo plazo

Para garantizar estabilidad a largo plazo, los equipos definen estándares de gobernanza que describen patrones de nombres, políticas de versionado y límites de permisos. Este enfoque evita la deriva de configuración conforme los servicios aumentan en número y complejidad. Las herramientas de cumplimiento automatizado validan el cumplimiento de estos estándares.

Las pruebas de carga periódicas confirman si los comportamientos de escalado siguen siendo predecibles a medida que evoluciona el ecosistema. Los equipos simulan distintos escenarios de tráfico para verificar que el enrutamiento de eventos, la capacidad de la base de datos y la concurrencia de funciones funcionan como se espera. Estas pruebas forman parte habitual de los ciclos de lanzamiento.

La documentación sigue siendo esencial. Los ingenieros mantienen registros de decisiones arquitectónicas que explican por qué se eligieron determinadas tecnologías. Esto ayuda a nuevos desarrolladores a comprender rápidamente la lógica detrás de cada patrón y mantener el sistema de forma responsable.

Temas populares

-

OpenTelemetry en producción...

OpenTelemetry en producción...En 2026, los sistemas distribuidos ya no son una …

-

Limitación de tasa y protec...

Limitación de tasa y protec...La limitación de tasa es uno de esos controles …

-

Comparación de copias de se...

Comparación de copias de se...Las copias de seguridad son de esas cosas que …

-

Redes de Alto Rendimiento: ...

Redes de Alto Rendimiento: ...Las redes de alto rendimiento se han convertido en …

-

Edge AI y TinyML: Cómo la i...

Edge AI y TinyML: Cómo la i...La inteligencia artificial en el borde se ha convertido …