Reale Bedrohungen durch Künstliche Intelligenz im Jahr 2025: Deepfake-Politik und Sprachangriffe

Künstliche Intelligenz (KI) ist längst keine Zukunftsvision mehr – sie entwickelt sich rasant und beeinflusst bereits Politik, Cybersicherheit und öffentliche Kommunikation. Stand Februar 2025 nehmen die realen Missbrauchsfälle von KI-Technologie bedrohliche Ausmaße an. Von Deepfake-Videos, die Politiker imitieren, bis hin zu Sprachklon-Tools für Betrug – der Missbrauch von KI stellt eine reale Gefahr für Gesellschaft, Wirtschaft und Demokratie dar.

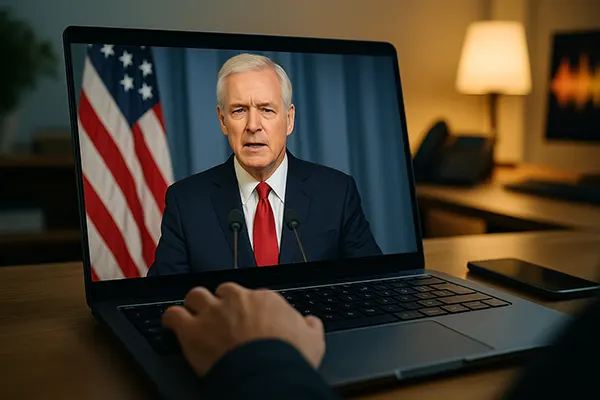

Manipulation des politischen Diskurses durch Deepfakes

Deepfake-Technologie, basierend auf generativen gegnerischen Netzwerken (GANs), ist heute so weit fortgeschritten, dass Laien echte Aufnahmen kaum noch von KI-generierten Videos unterscheiden können. Bei den US-Wahlen 2024 gingen mehrere Deepfake-Clips viral, in denen Kandidaten falsche Aussagen machen. Trotz schneller Faktenchecks war der Schaden am öffentlichen Vertrauen bereits angerichtet, da Millionen Menschen die Inhalte bereits gesehen hatten.

Auch in der EU verschärfte sich die Lage, etwa in Deutschland, wo ein Deepfake-Video eine führende Politikerin der Grünen mit erfundenen Klimapositionen darstellte. Obwohl der Clip innerhalb von 48 Stunden entlarvt wurde, kam es zu einer Welle von Online-Angriffen und Verschwörungstheorien. Regierungen haben Schwierigkeiten, Systeme zur Echtzeit-Erkennung zu implementieren oder Gesetze anzupassen, die mit der Geschwindigkeit dieser Bedrohung Schritt halten.

Besorgniserregend ist auch, wie einfach Deepfakes inzwischen zu erstellen sind. Früher benötigte man dafür leistungsstarke Computer und Fachwissen – heute genügen Smartphone-Apps. Diese Demokratisierung der Technologie bedeutet, dass praktisch jeder gefälschtes politisches Material erstellen und damit Einfluss auf die öffentliche Meinung nehmen kann.

Rechtliche Lücken und technische Grenzen

Obwohl Organisationen wie die Europäische Kommission und die US-Wahlkommission Richtlinien gegen Deepfakes erarbeitet haben, klafft eine große Lücke zwischen Theorie und Umsetzung. Nur wenige Länder haben bisher Strafgesetze speziell gegen KI-generierte Medienverfälschung erlassen.

Technische Lösungen wie Wasserzeichen oder digitale Herkunftsnachweise befinden sich noch in der Entwicklung. Start-ups wie TrueMedia und RealityGuard arbeiten an Erkennungsmechanismen, doch die Gegenseite entwickelt sich oft schneller weiter, als die Tools angepasst werden können.

Soziale Netzwerke spielen eine doppelte Rolle: Einige führen automatische Warnhinweise ein, andere agieren zögerlich oder gar nicht. Die grenzüberschreitende Natur der Verbreitung erschwert eine wirksame Regulierung erheblich.

KI-Stimmenklonen und Finanzbetrug

Stimmenklonen, früher ein Nischenthema spezialisierter Labore, ist heute dank freier Apps weit verbreitet. Mit nur wenigen Sekunden Tonaufnahme lassen sich täuschend echte Stimmkopien erzeugen. Kriminelle nutzen diese Technologie, um „CEO-Betrug“ zu begehen – dabei imitieren sie Führungskräfte und geben betrügerische Zahlungsanweisungen.

Im Februar 2025 wurde in Großbritannien ein CFO per Stimmen-Klon „telefonisch“ imitiert – das führte zu einem Überweisungsbetrug in Höhe von 2,3 Millionen Pfund. Laut Europol stieg die Zahl solcher Angriffe in Europa zwischen 2023 und 2024 um 320 %.

Auch Privatpersonen geraten ins Visier. Betrüger rufen mit gefälschten Stimmen angeblicher Angehöriger bei Senioren an und bitten um „dringende finanzielle Hilfe“. Diese Angriffe kombinieren emotionale Erpressung mit hochentwickelter Technik und sind kaum als klassische Betrugsmasche zu erkennen.

Schwierigkeiten bei der Erkennung synthetischer Stimmen

Im Gegensatz zu Textbetrug wirken Sprachangriffe persönlich und glaubwürdig. Banken und Unternehmen entwickeln neue Sicherheitsprotokolle, etwa Zwei-Faktor-Stimmenverifikation und KI-basierte Anomalie-Erkennung. Doch auch die Betrüger rüsten technisch auf.

Forschungsgruppen an Universitäten wie Oxford und MIT entwickeln Algorithmen zur Erkennung von Auffälligkeiten in synthetischer Sprache – etwa unnatürliche Pausen oder Tonhöhenabweichungen. Diese Lösungen sind jedoch datenintensiv und bisher nicht weit verbreitet.

Stimmenbiometrie galt lange als sicher – nun verlieren solche Systeme an Vertrauen. Viele Unternehmen setzen vermehrt auf kontextbezogene Identitätsprüfungen, ein Trend, der durch die Bedrohung durch Stimmenklonung beschleunigt wurde.

Geopolitische Risiken und nationale Sicherheitsfragen

KI-generierte Desinformation ist nicht bloß ein Ärgernis – sie wird zur Waffe im Informationskrieg. Geheimdienste der NATO-Staaten, darunter auch der britische GCHQ, berichten von steigenden Aktivitäten staatsnaher Akteure, die Deepfakes und synthetische Stimmen gezielt zur Destabilisierung nutzen.

Ein Vorfall: Mit Russland verbundene Gruppen veröffentlichten Videos ukrainischer Offizieller, die angeblich kapitulierten. Diese Fälschungen lösten kurzzeitig Panik aus, bevor sie entlarvt wurden. Solche Kampagnen zielen auf Moral, Wahlausgänge und gesellschaftliche Stabilität.

Auch China nutzt KI-Moderatoren in staatlichen Auslandsmedien, um kontrollierte Inhalte zu verbreiten. Zwar legal im eigenen Land, werfen diese Taktiken Fragen über die globale Meinungsbeeinflussung durch autoritäre Regime auf.

Globale KI-Governance stärken

Internationale Zusammenarbeit ist derzeit unzureichend. Zwar schlug die UNESCO einen ethischen Rahmen für KI vor, doch nur wenige Länder haben diesen bisher gesetzlich verankert. Der G7-Gipfel 2024 forderte gemeinsame Regeln, aber es herrscht Stillstand.

Experten fordern eine multilaterale Kooperation von Zivilgesellschaft, Forschung und Industrie. Eine Möglichkeit wäre die Gründung globaler Aufsichtsbehörden, die KI-Missbrauch überwachen und auf internationale Bedrohungen reagieren können.

Letztlich braucht es nicht nur Regulierung, sondern auch Aufklärung. Medienkompetenz, transparente Kennzeichnung synthetischer Inhalte und öffentliche Informationskampagnen sind essenziell, um der Manipulation mit KI etwas entgegenzusetzen.

Beliebte Themen

-

OpenTelemetry in der Produk...

OpenTelemetry in der Produk...Im Jahr 2026 sind verteilte Systeme der Standard und …

-

Rate limiting und Schutz vo...

Rate limiting und Schutz vo...Rate limiting ist eine Massnahme, die auf einem Diagramm …

-

Backup Comparison in 2026: ...

Backup Comparison in 2026: ...Backups are one of those things most people only …

-

High-Performance Networking...

High-Performance Networking...High-Performance Networking ist zu einer zentralen Voraussetzung für moderne …

-

Edge AI und TinyML: Wie Int...

Edge AI und TinyML: Wie Int...Edge-basierte künstliche Intelligenz gehört zu den bedeutendsten technologischen Entwicklungen …