Come Creare Programmaticamente un’Ecosistema di Microservizi Serverless nel 2025

Costruire un ecosistema di microservizi flessibile ed efficiente nel 2025 richiede una chiara comprensione delle capacità serverless moderne, dei flussi di sviluppo, degli standard di sicurezza e dell’automazione cloud-native. L’approccio descritto di seguito riflette le pratiche usate dai team di ingegneria che adottano architetture serverless per garantire scalabilità, resilienza e riduzione dei costi operativi senza usare infrastrutture non gestite.

Principi di Progettazione per un’Architettura Serverless di Microservizi

I team di sviluppo nel 2025 iniziano normalmente con una strategia di decomposizione basata sui domini aziendali, invece che su livelli tecnici. Questo approccio aiuta a mantenere i confini tra i servizi ed evita l’eccessivo accoppiamento, permettendo a ogni componente di evolvere in modo indipendente. I provider cloud offrono oggi sistemi di routing degli eventi più avanzati, facilitando l’applicazione dei principi domain-driven.

Gli ecosistemi serverless utilizzano flussi di comunicazione orientati agli eventi. Invece delle classiche catene sincrone di richieste, gli sviluppatori sfruttano bus di eventi come AWS EventBridge, Google Eventarc o Azure Event Grid. Questi sistemi riducono i colli di bottiglia e migliorano la tolleranza ai guasti, poiché le funzioni elaborano gli eventi in modo indipendente.

La gestione della configurazione ha un ruolo centrale. Gli sviluppatori utilizzano strumenti di infrastructure-as-code come AWS CDK, Pulumi o Terraform per definire funzioni Lambda, API gestite, code e state machine. Con l’IaC, i team garantiscono ambienti riproducibili e una governance più stabile tra sviluppo, staging e produzione.

Costruire una Base Consistente per i Microservizi

Per mantenere coerenza tra i servizi, gli sviluppatori usano librerie condivise per log, metriche e tracing. Nel 2025 OpenTelemetry rimane lo standard per il tracing distribuito, offrendo visibilità unificata su servizi implementati tramite funzioni serverless, container o workflow gestiti.

I flussi di autenticazione sono di solito centralizzati tramite provider moderni come Amazon Cognito, Auth0, Azure AD B2C o Google Identity. Ogni microservizio valida i token in autonomia, riducendo la necessità di comunicare direttamente con il sistema di identità.

I team si affidano anche a controlli automatici. I provider cloud integrano regole predefinite per crittografia, rotazione dei segreti e limiti di rete. Questi controlli automatici riducono gli errori manuali e rafforzano l’affidabilità dei sistemi in produzione.

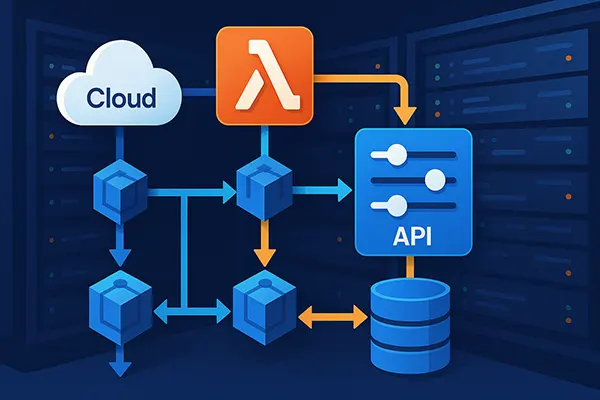

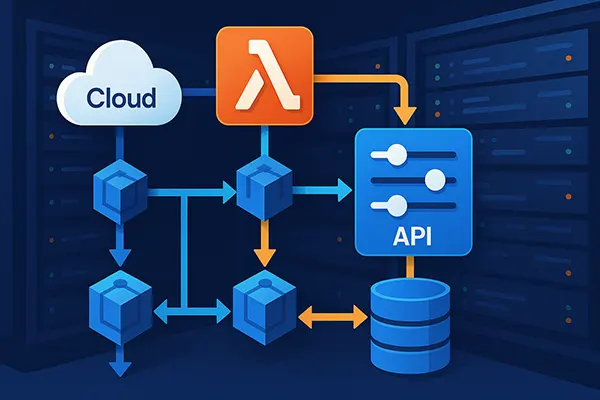

Implementare Microservizi con Funzioni Serverless

Le funzioni serverless restano nel 2025 il principale motore esecutivo dei microservizi. AWS Lambda, Google Cloud Functions e Azure Functions offrono prestazioni migliori, minori tempi di cold start e capacità di gestire operazioni più intensive rispetto agli anni precedenti. Molti team combinano funzioni serverless con runtime serverless basati su container, come AWS Fargate o Cloud Run.

Gli API gateway funzionano come punto di ingresso controllato. Tramite regole di routing, politiche di throttling e validazione delle richieste, garantiscono comportamenti prevedibili, mantenendo stabilità anche in caso di picchi improvvisi di traffico.

La gestione dello stato è affidata a database gestiti e motori di workflow. DynamoDB, Firestore, Azure Cosmos DB e i database relazionali cloud-native offrono transazioni, scalabilità automatica e schemi flessibili. Per orchestrare i workflow complessi vengono usati Step Functions, Cloud Workflows o Durable Functions.

Pattern Efficienti per Microservizi Serverless

Il chaining di funzioni basato su eventi è oggi una pratica diffusa. Invece di implementare handler monolitici, gli sviluppatori dividono la logica in funzioni dedicate, attivate da code o bus di eventi. Ciò migliora il parallelismo e riduce la latenza sotto carico elevato.

Il pattern Saga continua a essere molto utilizzato per gestire operazioni distribuite. Coordinando transazioni locali e azioni compensative, aiuta a mantenere la consistenza dei dati senza affidarsi a transazioni fortemente accoppiate. I motori di workflow facilitano l’implementazione delle Saga.

L’ottimizzazione dei costi è ampiamente automatizzata. I team monitorano durata delle funzioni, memoria e concorrenza, adattandole tramite pipeline IaC. Gli strumenti moderni suggeriscono impostazioni ottimali riducendo i costi senza penalizzare le prestazioni.

Sicurezza, CI/CD e Pratiche Operative nel 2025

Nel 2025 le pratiche di sicurezza si basano su controlli automatici. I provider cloud offrono rule set che verificano policy IAM, esposizione delle API e configurazione dello storage. Queste verifiche vengono integrate nelle pipeline CI/CD.

Le pipeline di integrazione continua utilizzano ambienti di build effimeri per ridurre i rischi della supply chain. GitHub Actions, GitLab CI e AWS CodeBuild supportano artefatti firmati e storage protetto, diventati uno standard minimo per gli ambienti enterprise.

I processi operativi sfruttano scaling automatico e monitoraggio avanzato. Con strumenti come CloudWatch, Stackdriver o Azure Monitor, gli ingegneri rilevano anomalie in tempo reale. I sistemi di monitoraggio predittivo basati su AI permettono di anticipare i picchi di carico.

Manutenzione a Lungo Termine e Governance

Per garantire stabilità nel tempo, i team definiscono standard di governance che includono convenzioni di naming, politiche di versioning e limiti sui permessi. Queste regole evitano la deriva di configurazione quando il numero dei servizi aumenta.

I test di carico regolari confermano la prevedibilità dello scaling. Simulando diversi scenari di traffico, i team verificano il comportamento del routing degli eventi, della capacità dei database e della concorrenza delle funzioni.

La documentazione rimane essenziale. I team mantengono architetture e decision log per spiegare le scelte tecnologiche. Ciò aiuta i nuovi sviluppatori a comprendere rapidamente la logica dell’ecosistema e a mantenerlo in modo responsabile.

Argomenti più popolari

-

Confronto dei backup nel 20...

Confronto dei backup nel 20...I backup sono una di quelle cose che molte …

-

High-Performance Networking...

High-Performance Networking...Il networking ad alte prestazioni è diventato un requisito …

-

Edge AI e TinyML: come l’in...

Edge AI e TinyML: come l’in...L’intelligenza artificiale eseguita a livello locale è diventata uno …

-

Come Creare Programmaticame...

Come Creare Programmaticame...Costruire un ecosistema di microservizi flessibile ed efficiente nel …

-

Il Ruolo dell’Intelligenza ...

Il Ruolo dell’Intelligenza ...L’intelligenza artificiale è diventata un elemento pratico nelle operazioni …