Wie man 2025 ein serverloses Mikrodienst-Ökosystem programmatisch aufbaut

Der Aufbau eines flexiblen und effizienten Mikrodienst-Ökosystems im Jahr 2025 erfordert ein klares Verständnis moderner serverloser Möglichkeiten, Entwicklungsabläufe, Sicherheitsstandards und cloudnativer Automatisierung. Der untenstehende Ansatz spiegelt Praktiken wider, die von Engineering-Teams verwendet werden, die serverlose Architekturen einsetzen, um sicher zu skalieren, Ausfallsicherheit zu gewährleisten und den betrieblichen Aufwand ohne unkontrollierte Infrastruktur zu reduzieren.

Grundprinzipien einer serverlosen Mikrodienst-Architektur

Engineering-Teams beginnen 2025 in der Regel mit einer Serviceaufteilung basierend auf Geschäftsdomänen statt technischen Schichten. Dieser Ansatz hilft dabei, klare Grenzen zwischen Diensten zu wahren und enge Kopplungen zu vermeiden, sodass jede Komponente unabhängig weiterentwickelt werden kann. Cloud-Anbieter stellen inzwischen fortschrittlichere Ereignisroutingsysteme bereit, die domänenorientierte Strukturen erleichtern.

Serverlose Ökosysteme verlassen sich heute auf ereignisorientierte Kommunikationsabläufe. Anstelle synchroner Anfragenketten nutzen Entwickler Ereignisbusse wie AWS EventBridge, Google Eventarc oder Azure Event Grid. Diese Systeme verringern Engpässe und verbessern die Fehlertoleranz, da Funktionen Ereignisse unabhängig voneinander verarbeiten.

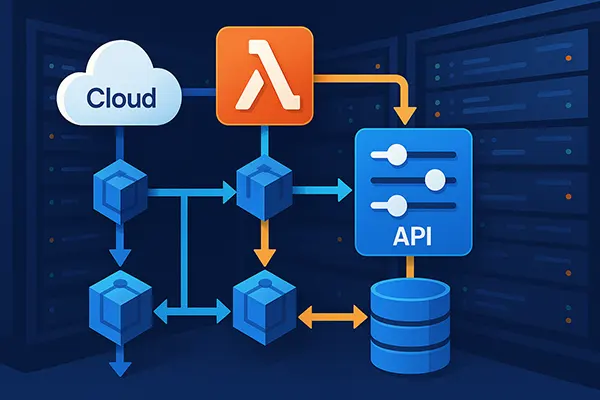

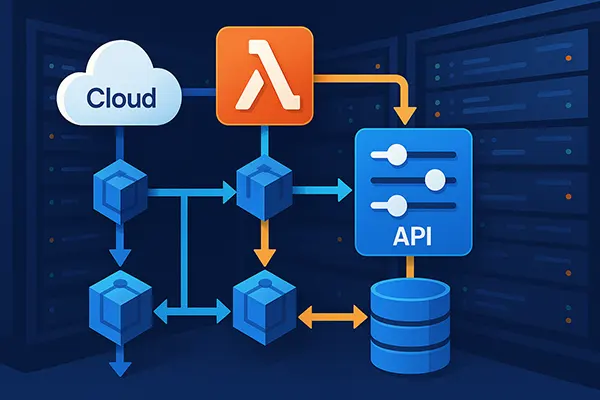

Das Konfigurationsmanagement spielt ebenfalls eine zentrale Rolle. Entwickler verwenden häufig Infrastructure-as-Code-Frameworks wie AWS CDK, Pulumi oder Terraform, um Lambda-Funktionen, verwaltete APIs, Warteschlangen und Zustandsmaschinen zu definieren. Mit IaC werden reproduzierbare Umgebungen und eine bessere Governance über Entwicklungs-, Staging- und Produktionssysteme hinweg gewährleistet.

Eine konsistente Grundlage für Mikrodienste schaffen

Um Konsistenz sicherzustellen, verwenden Entwickler gemeinsame Bibliotheken für Logging, Metriken und Tracing. 2025 bleibt OpenTelemetry der Standard für verteilte Traces und bietet einheitliche Sichtbarkeit über Funktionen, Container und verwaltete Workflows hinweg. Die Beobachtbarkeit vereinfacht Debugging und Leistungsüberwachung.

Authentifizierungsprozesse werden meist zentralisiert über moderne Identitätsanbieter umgesetzt. Amazon Cognito, Auth0, Azure AD B2C und Google Identity bieten ausgereifte Werkzeuge für benutzerfreundliche Anmeldevorgänge und Tokenvalidierung. Jeder Mikrodienst prüft Tokens eigenständig, was direkte Kommunikationswege mit Identitätssystemen reduziert.

Entwickler verlassen sich zudem stark auf automatisierte Richtlinien. Cloud-Anbieter stellen integrierte Regeln für Verschlüsselung, Geheimnisrotation und Netzwerkgrenzen bereit. Diese Automatisierungen reduzieren Konfigurationsfehler und stärken die Zuverlässigkeit produktiver Systeme.

Mikrodienste mit serverlosen Funktionen implementieren

Serverlose Funktionen bleiben 2025 die zentralen Ausführungseinheiten in Mikrodienst-Ökosystemen. AWS Lambda, Google Cloud Functions und Azure Functions bieten hohe Leistung, geringere Kaltstarts und die Möglichkeit, ressourcenintensivere Abläufe als früher auszuführen. Viele Teams kombinieren serverlose Funktionen mit containerbasierten serverlosen Laufzeiten wie AWS Fargate oder Cloud Run.

API-Gateways fungieren als kontrollierte Einstiegspunkte für externe Kommunikation. Durch Routingregeln, Drosselungsrichtlinien und Anfragevalidierung stellen API-Gateways vorhersehbares Verhalten sicher, insbesondere bei plötzlich ansteigender Nachfrage.

Die Zustandsverwaltung wird durch verwaltete Datenbanken und Workflow-Engines erreicht. DynamoDB, Firestore, Azure Cosmos DB und cloudnative relationale Dienste unterstützen Transaktionen, flexible Schemata und automatische Skalierung. Für komplexe Abläufe nutzen Entwickler häufig Step Functions, Cloud Workflows oder Durable Functions.

Effiziente Muster für serverlose Mikrodienste

Ereignisgesteuerte Funktionsketten sind inzwischen weit verbreitet. Entwickler teilen Logik in spezialisierte Funktionen auf, die durch Warteschlangen oder Ereignisbusse ausgelöst werden. Dies verbessert Parallelisierung, reduziert Latenz und erzeugt vorhersehbare Skalierungsverhalten bei hoher Last.

Das Saga-Muster gewinnt weiterhin an Bedeutung für verteilte Abläufe. Durch die Koordination lokaler Transaktionen und kompensatorischer Schritte bei Fehlern bleibt Datenkonsistenz gewahrt, ohne auf fest gekoppelte Transaktionen angewiesen zu sein. Workflow-Engines unterstützen diese Muster transparent.

Kostenoptimierung erfolgt zunehmend programmatisch. Teams beobachten Funktionsdauer, Speicherkonfiguration und Parallelitätseinstellungen und passen diese über IaC-Pipelines an. Moderne Werkzeuge schlagen automatisch optimale Werte vor, um Kosten zu senken, ohne Leistungseinbußen.

Sicherheit, CI/CD und Betriebspraktiken im Jahr 2025

Sicherheitspraktiken basieren 2025 stark auf automatisierter Richtliniendurchsetzung. Cloud-Anbieter liefern voreingestellte Regelwerke zur Überprüfung von IAM-Richtlinien, API-Exposition und Datenspeicherung. Entwickler integrieren diese Scans in ihre CI/CD-Pipelines, um Risiken frühzeitig zu erkennen.

CI-Pipelines verwenden kurzlebige Build-Umgebungen zur Minimierung von Lieferkettenrisiken. GitHub Actions, GitLab CI und AWS CodeBuild unterstützen signierte Artefakte und manipulationsresistente Speicher, was inzwischen als Mindeststandard gilt.

Betriebsprozesse profitieren von automatischer Skalierung und fortschrittlicher Überwachung. Mit Echtzeitanalysen über CloudWatch, Stackdriver oder Azure Monitor können Ingenieure Anomalien frühzeitig erkennen. KI-gestützte Prognoseüberwachung hilft zudem, Lastspitzen vorherzusehen und Kapazitäten rechtzeitig anzupassen.

Langfristige Wartung und Governance

Um langfristige Stabilität sicherzustellen, definieren Teams Governance-Standards für Namensschemata, Versionierungsrichtlinien und Berechtigungsgrenzen. Diese verhindern Konfigurationsabweichungen, wenn die Anzahl der Dienste wächst. Automatisierte Compliance-Werkzeuge prüfen, ob Standards eingehalten werden.

Regelmäßige Lasttests bestimmen, ob Skalierungsverhalten weiterhin stabil bleibt. Teams simulieren unterschiedliche Verkehrsszenarien, um sicherzustellen, dass Ereignisrouting, Datenbankkapazität und Funktionsparallelität wie erwartet arbeiten. Diese Tests sind mittlerweile Bestandteil regulärer Releasezyklen.

Dokumentation bleibt unverzichtbar. Ingenieure pflegen Architekturentscheidungsprotokolle, um zu erläutern, weshalb bestimmte Technologien gewählt wurden. Dies erleichtert neuen Entwicklern das Verständnis hinter jedem Muster und fördert nachhaltigen Betrieb.

Beliebte Themen

-

Backup Comparison in 2026: ...

Backup Comparison in 2026: ...Backups are one of those things most people only …

-

High-Performance Networking...

High-Performance Networking...High-Performance Networking ist zu einer zentralen Voraussetzung für moderne …

-

Edge AI und TinyML: Wie Int...

Edge AI und TinyML: Wie Int...Edge-basierte künstliche Intelligenz gehört zu den bedeutendsten technologischen Entwicklungen …

-

Wie man 2025 ein serverlose...

Wie man 2025 ein serverlose...Der Aufbau eines flexiblen und effizienten Mikrodienst-Ökosystems im Jahr …

-

Die Rolle der künstlichen I...

Die Rolle der künstlichen I...Künstliche Intelligenz ist zu einem praktischen Bestandteil von Glücksspielprozessen …